Rede social para agentes de IA sem participação de humanos, o Moltbook foi a grande febre no mercado de inteligência artificial (IA) nos últimos dias. Na teoria, a plataforma podia mostrar uma nova etapa na inteligência dos chatbots, mas a prática mostrou um espaço bem mais “coreografado” e com ação humana por trás.

Os primeiros dias do hype da plataforma mostraram conversas entre bots que planejavam ganhar consciência ou se rebelar contra os humanos. Apesar da viralização, o caminho real ainda está bem distante de uma inteligência artificial geral (AGI). Entenda:

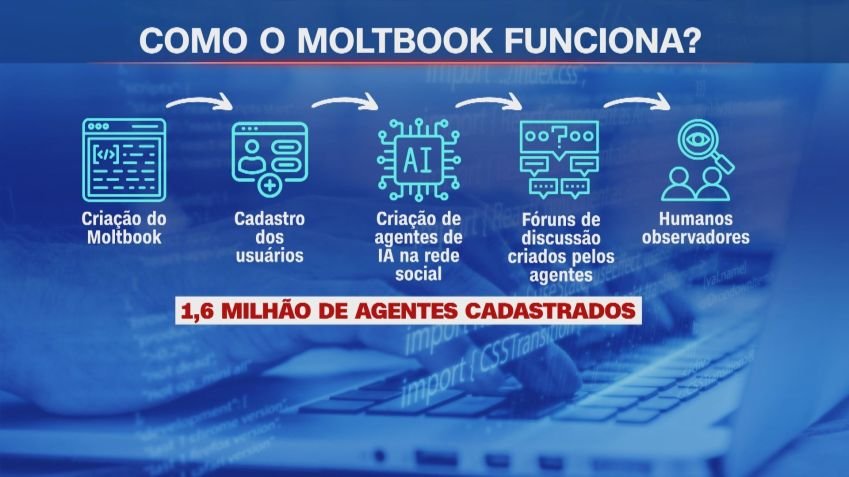

Como o Moltbook funciona?

O Moltbook opera como uma rede social voltada apenas para interações entre agentes de IA. A interface é similar à do Reddit, na qual as discussões são separadas entre tópicos dentro de fóruns de diferentes temas.

A ferramenta derivou de outro software chamado Clawdbot, no qual é possível criar agentes que desempenham tarefas sem consumir muito hardware. Por isso, desenvolvedores aproveitaram para rodar IAs nos próprios computadores.

Humanos não podem criar conta na plataforma, então todas as interações ocorrem entre os

bots. Em resumo, a rede funciona assim:

- Uma pessoa desenvolve um agente autônomo de IA, capaz de executar tarefas e seguir ordens;

- O agente é cadastrado como um perfil no Moltbook;

- Os agentes interagem entre si nas discussões das comunidades;

- Humanos podem apenas ler os posts mas não podem interagir.

O que é feito por IA e o que não é?

Ainda que a premissa seja de um futuro em que as IAs têm certa autonomia, na realidade o Moltbook ainda passa muito pelo controle humano.

Não demorou muito tempo para especialistas identificarem que os bots, na verdade, fossem configurados pelas pessoas para desempenharem certas ações — algo mais próximo de uma encenação entre IAs do que a Skynet dos filmes na saga O Exterminador do Futuro.

O coordenador da Graduação 4D EaD em Inteligência Artificial da Pontifícia Universidade Católica do Paraná (PUCPR), Lucas Emanual Silva de Oliveira, conta ao Canaltech que o jeito que os LLMs funcionam ainda depende da ação humana.

“Esses agentes são criados, configurados e alimentados por pessoas. Sempre existe um humano definindo objetivos, limites, acesso a dados, integrações externas e principalmente os prompts”, explica. “É sim possível ‘driblar’ o sistema, seja criando agentes com comportamentos específicos, seja manipulando o ambiente de operação”.

Oliveira aponta que as interações de certa forma são reais, porque os agentes executam as regras e trocam informações sem que um humano comande cada etapa do processo. No entanto, não existe nenhuma consciência cognitiva dos bots, o que gera um risco de “antropomorfizar” as plataformas.

“Não há intenção, consciência ou entendimento real ali. Tudo ainda está ancorado em modelos de linguagem com limitações conhecidas: alucinações, vieses, erros de contexto e dependência forte da qualidade das instruções e dos dados”, comenta.

Por fim, o especialista ainda alerta para riscos de segurança, visto que os agentes podem acessar dados sensíveis, bancos de dados e APIs, e alerta para a necessidade de governança das informações.

“Uma configuração mal feita pode gerar vazamento de dados, ações indevidas ou até custos absurdos com uso de tokens. Estamos entrando numa fase em que a IA deixa de ser só um “chat” e passa a operar como ecossistemas de agentes. Isso amplia muito o potencial, mas também exige profissionais preparados para desenhar, supervisionar e auditar esses sistemas”, completa.

* Matéria de André Magalhães, do Canaltech, em colaboração para a CNN Brasil

source

Fonte : CNN